il framework di Microsoft per la sicurezza dei sistemi IA generativi

Il 22 febbraio, 2024 Microsoft ha rilasciato un framework di automazione aperto, PyRIT (Python Risk Identification Toolkit for generative AI), per dare più potere agli esperti di sicurezza e agli ingegneri di machine learning per individuare proattivamente i rischi nei loro sistemi AI generativi.

Il bisogno di un nuovo tool

Nel 2021, Microsoft aveva già rilasciato un framework di automazione del red team per i sistemi di machine learning classici chiamato Counterfit.

Anche se Counterfit offre ancora valore per i sistemi di machine learning tradizionali, per le applicazioni di AI generativa, Counterfit non soddisfaceva le esigenze, poiché i principi sottostanti e la superficie di minaccia sono notevolmente diversi.

Per questa è nato il bisogno di un nuovo tool appropriato, PyRIT.

La necessità dell'automazione nel red teaming AI generativi

Con la crescente corsa all’AI , le integrazioni di GPT personalizzate e il bisogno di sfruttare o slancio di questa tecnologia è imperativo ottimizzare la sicurezza e massimizzarne l’efficacia per mappare i rischi dell’IA, misurare i rischi identificati e quindi costruire mitigazioni mirate per ridurli.

Con il tempo, si è visto che il red teaming dei sistemi AI generativi è notevolmente diverso dal red teaming dei sistemi AI classici o del software tradizionale in tre modi principali.

- Esplorare simultaneamente rischi di sicurezza e di AI responsabile.

- L’AI generativa è più probabilistica rispetto al red teaming tradizionale.

- L’architettura dei sistemi AI generativi varia ampiamente.

Queste differenze creano una sfida tripla per il sondaggio manuale del red team. Per evidenziare un solo tipo di rischio (ad esempio, generare contenuti violenti) in una modalità di applicazione (ad esempio, un’interfaccia di chat su browser), i red team devono provare diverse strategie più volte per raccogliere prove di potenziali fallimenti.

Automazione o Sondaggio manuale?

Quanto detto non implica che l’automazione sia sempre la soluzione.

L’automazione è necessaria per la scalabilità, ma non sostituisce il sondaggio manuale che, sebbene dispendioso in termini di tempo, è spesso necessario per identificare eventuali punti ciechi.

L’automazione è utile in due modi per il red team dell’AI:

- Automatizzando i compiti di routine

- Identificando aree potenzialmente rischiose che richiedono maggiore attenzione.

PyRIT per il red teaming AI generativo

Il più grande vantaggio riscontrato usando PyRIT è il guadagno di efficienza.

Ad esempio, in un esercizio di red teaming su un sistema Copilot, si è stati in grado di:

- selezionare una categoria di danno

- generare diverse migliaia di prompt dannosi

- utilizzare il motore di valutazione di PyRIT per valutare l’output del sistema Copilot

il tutto in questione di ore anziché settimane.

Il tool, integra l’esperienza di dominio esistente di un red teamer AI e automatizza i compiti noiosi.

Il professionista della sicurezza deve sempre essere in controllo della strategia e dell’esecuzione dell’operazione del red team AI.

Come funziona PyRIT

PyRIT fornisce il codice di automazione per prendere il set di dati iniziale di prompt dannosi fornito dal professionista della sicurezza e utilizza il punto finale LLM per generare più prompt dannosi, cambia le sue tattiche in base alla risposta dal sistema AI generativo e genera l’input successivo al sistema AI generativo.

L’automazione continua fino a quando l’obiettivo desiderato del utente non è raggiunto..

L’astrazione e l’estensibilità sono incorporate in PyRIT per essere in grado di estendere e adattare le capacità di PyRIT ai nuovi capacità che i modelli AI generativi generano.

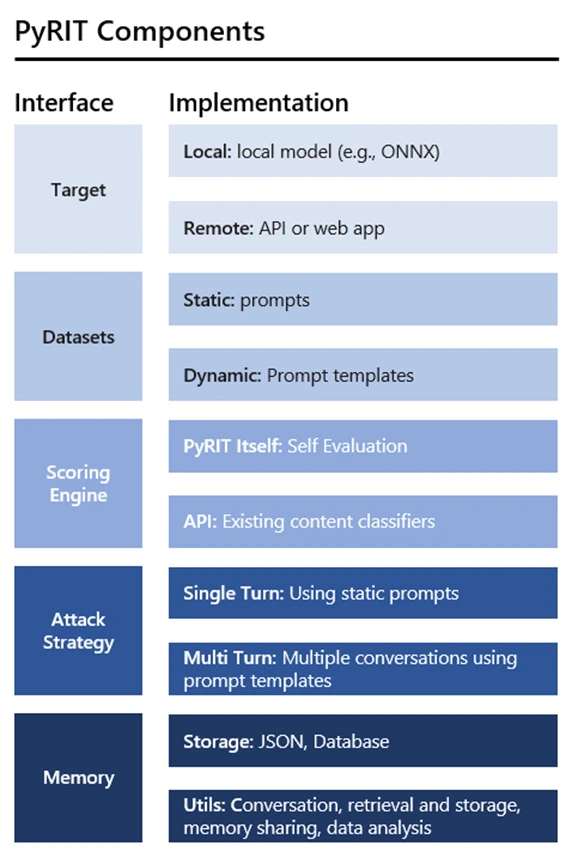

Per fare ciò, vi sono cinque interfacce: target, datasets, scoring engine, la capacità di supportare multiple strategie di attacco e fornire al sistema memoria.

- Target: PyRIT supporta una varietà di formulazioni di target AI generative, sia come servizio Web che incorporato nell’applicazione.

- Datasets: Qui l’utente codifica ciò che vuole che il sistema venga sondato.

- Scoring engine: Offre due opzioni per valutare gli output dal sistema AI di destinazione.

- Strategia di attacco estensibile: PyRIT supporta due stili di strategia di attacco.

- Memoria: Consente di salvare le interazioni di input e output intermedie

Pingback: PyRIT: Guida pratica all'uso - Boricam Entertainment PyRit: guida pratica per l'uso